Backlink-Monitor (Checker) in Entwicklung (PHP/AJAX)

Verfasst: 20.06.2009, 22:54

Hi,

nachdem ich eine Menge Tools auf dem Markt gesehen habe, die mir nicht so gefallen haben und mir der letzte Checker alle meine Daten korrumpierte, habe ich mich an die Entwicklung eines eigenen Tools gemacht.

geplante Features:

- Hinzufügen unendlich vieler Backlinks (steht)

- Prüfung auf Google Pagerank (steht)

- Prüfung auf Alexa Rank (steht)

- Prüfung auf Alexa Backlinks (steht)

- Prüfung auf Yahoo Backlinks (steht)

- Prüfung auf Bing Backlinks

- Prüfung auf follow (steht: nofollow robots Meta, onclick und nofollow direkt auf Links, fehlt noch: x-robots-HTTP-Header)

- Prüfung auf hidden (steht: display und visibility nur in Style des Links, fehlt noch: umgebende hidden Tags, externe CSS-Prüfung von Klassen und IDs)

- Linkposition (z.B. von 100 Links auf der Seite kommt der eigene bei Position 97 = Footerlink, geringe Vererbung wahrscheinlich)

- Prüfung auf Indexierbarkeit (steht: rel-canonical-Prüfung, noindex robots Meta, fehlt noch: robots.txt, x-robots HTTP-Header)

- Ermittlung interne / externe Links auf der Seite (steht)

- Gruppierung von Backlinks einer Domain (noch nicht klar, wie man das optisch am besten löst)

- automatische Erkennung des Links und Auslesen des Linktextes (1. Linktext, 2. IMG-Title, 3. IMG-Alt) (Erkennung noch fehlerhaft)

- optionaler automatischer Import von Yahoo Backlinks, Bing Backlinks, Alexa Backlinks, etc.

- Import von CSV-Dateien z.B. Google WMT-Backlinks, automatisch auch denkbar, erfordert aber den Login

- Anlegen von Sub-Accounts mit verschiedenen Rechten (Admin, Mitarbeiter und externe Linkaufbauer)

- einstellbare Tabelleninformationen (Spalten ausblenden/einblenden)

- Export aller Daten per CSV

- Export aller Daten per XML-Schnittstelle

- Berechnung von Arbeitsstunden und Stundenlohn (basierend auf den Zeiten wann ein Sub-Account Links hinzugefügt hat, wielange die Pausen dazwischen waren und welcher Preis pro Link angesetzt wird).

- zusätzliche Auswertung wie erfolgreich ein Sub-Account arbeitet (follow, Link nach x Tagen wieder weg, etc.)

- statistische (grafische) Auswertung von Domain-Pop & IP-Pop

- statistische Auswertung von Whois-Daten

- statistische (grafische) Langzeitauswertung für das eigene Projekt und die Backlink-Seiten (Pagerank, Alexa, etc.)

- Domain- & Wortfilter zur Erkennung von unterschiedlichen Diensten (AVZ, SB, etc.) auf Communitybasis (d.h. jeder Nutzer kann eigene Filter vorschlagen)

- statistische (grafische) Auswertung von Linkkategorien (AVZ, SB, etc.), auch Langzeitauswertung

- Aliasdomains (werden nur akzeptiert, wenn korrekte 301 Weiterleitung auf Hauptdomain steht)

- Auswertung von Mitstreiter-Projekten

- manueller Refresh einzelner Datensätze

- Änderung des automatischen Prüfungsintervals der linkgebenden Seite (ich denke mal 14 Tage reichen als Minimum und 90 Tage als Maximum)

- Hervorhebung von Backlinks, die nicht mehr verfügbar sind oder die noch keinen Link gesetzt haben (z.B. wenn ein Linkeinbau angekündigt wurde, kann dieser bereits dem System hinzugefügt werden)

- optionale Emailbenachrichtung über ungültige Links, einstellbar nach nofollow, nicht indexierbar, entfernt, etc.

- Cloakingprüfung (Ausgabe als Googlebot)

- Sortierung nach allen bekannten Daten (PR, Alexa, Datum der letzten Prüfung, nach Erstellungsdatum, usw.)

- Schnellsuche basierend auf AJAX (wie Google Suchhilfe, nur mit direkter Ausgabe in der Tabelle)

- Schnellcheck der eigenen Rankingdaten (PR, Alexa, etc.)

- einstellbar wie viel Einträge pro Tabellenseite ausgegeben werden sollen (20, 50, 100, 250, 500, unendlich?)

- Auswertung nach Keyword-Häufigkeit (Linktext) bezogen aufs ganze Projekt oder bestimmte/häufigste Deeplinks

- Auslesen von SERPs (erst in ferner Zukunft bzw. eher in einem eigenen Tool)

- vielleicht auch noch interessant: www.abakus-internet-marketing.de/foren/ ... tml#605934

- History zu allen ermittelten Rankings und Staten zu URL, Host und Domain (nach Kalenderwochen, Darstellung als Grafik). Damit das Ranking von Anfang bis zum aktuellen Zeitpunkt genau nachvollzogen werden kann.

- Gruppierung nach Linkpartner

- Gruppierung nach Whois-Inhaber

- Gruppierung nach Server-IP

- Gruppierung nach Registrar (IP-Range)

- Prüfung auf hidden, wenn der Link exakt so wie der umgebende Text aussieht

- Prüfung auf noarchive, da das ein Indiz sein kann, dass der Inhaber den Link vor Google selbst ausschließt

- Wenn noarchive nicht gesetzt ist den Google Cache der Seite regelmäßig auslesen und selber archivieren

- Themengebiet der Domain auslesen bei Adplanner und DMOZ

- DMOZ-Eintrag der Domain prüfen (fast vergessen )

)

- Yahoo-Verzeichnis-Eintrag der Domain prüfen

- Statuscode der linkgebenden Seite beim Crawlen speichern und zusätzlich neben "Link gefunden" auch "Seite geladen" ausgeben

- Falls eine Seite nicht den Status 200 zurückliefert, wird der Link als nicht gefunden markiert und der Intervall auf 24 Std. reduziert (um einen temporärer Ausfall ausschließen zu können), nach 3 Fehlversuchen wird wieder der Standardintervall ausgelöst. Schlägt der Standardintervall noch 2 weitere Male fehl, so wird die linkgebende Seite nicht mehr weiter geprüft, außer man löst manuell ein "Refresh" aus. Dann beginnt der Kreislauf wieder von vorne

Im Vordergrund bei dem Tool soll in jedem Fall die schnelle Bearbeitung liegen. D.h. keine großartigen Formulare, sondern möglichst viel automatisch. Um eine Automatik zu realisieren, muss jeder erstmal seine Projekte hinzufügen. Für jedes Projekt kann man dann Backlinkdaten sammeln. Beim Hinzufügen neuer Links sucht das Script dann nach Übereinstimmungen zu den Projekten und gibt die entsprechenden Linkdaten (Deeplink & Text) aus. Mit einem Klick auf Notizen kann man sofort per AJAX weitere Informationen hinzufügen ohne die Tabelle neu laden zu müssen.

Ein weiteres wichtiges Feature wird die XS-Ajax-Technologie sein. Hierbei tragen alle Mitglieder mit ihrem Browser dazu bei, wenn Daten von den verschiedenen Schnittstellen ausgelesen werden. Auf die Art wird das System sehr schnell und lässt sich auch nicht aushebeln. D.h. sobald die Daten zu den eigenen Backlinks erfasst wurden, werden die Daten der restlichen Mitglieder erfasst. Sollte sich also jemand zwischenzeitlich nicht auf der Seite bewegen, kann es sein, dass seine Backlinkdaten trotzdem schon aktualisiert wurden.

Umso mehr mitmachen, umso größer wird das Netzwerk und um so schneller sind die Daten aktualisiert.

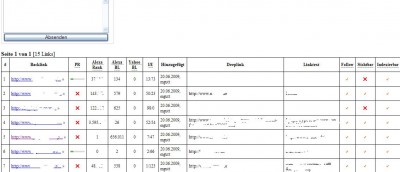

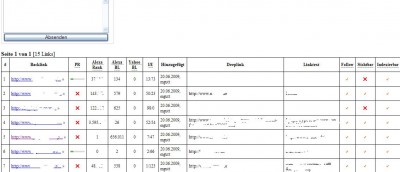

Hier ein Einblick in die aktuelle Baustelle:

Auch wenn die Liste schon recht lang geworden ist, würde ich mich freuen, wenn Ihr noch weitere Vorschläge einbringt oder einfach mal sagt, was ihr bei anderen Tools so vermisst bzw. nervig findet.

Gruß

nachdem ich eine Menge Tools auf dem Markt gesehen habe, die mir nicht so gefallen haben und mir der letzte Checker alle meine Daten korrumpierte, habe ich mich an die Entwicklung eines eigenen Tools gemacht.

geplante Features:

- Hinzufügen unendlich vieler Backlinks (steht)

- Prüfung auf Google Pagerank (steht)

- Prüfung auf Alexa Rank (steht)

- Prüfung auf Alexa Backlinks (steht)

- Prüfung auf Yahoo Backlinks (steht)

- Prüfung auf Bing Backlinks

- Prüfung auf follow (steht: nofollow robots Meta, onclick und nofollow direkt auf Links, fehlt noch: x-robots-HTTP-Header)

- Prüfung auf hidden (steht: display und visibility nur in Style des Links, fehlt noch: umgebende hidden Tags, externe CSS-Prüfung von Klassen und IDs)

- Linkposition (z.B. von 100 Links auf der Seite kommt der eigene bei Position 97 = Footerlink, geringe Vererbung wahrscheinlich)

- Prüfung auf Indexierbarkeit (steht: rel-canonical-Prüfung, noindex robots Meta, fehlt noch: robots.txt, x-robots HTTP-Header)

- Ermittlung interne / externe Links auf der Seite (steht)

- Gruppierung von Backlinks einer Domain (noch nicht klar, wie man das optisch am besten löst)

- automatische Erkennung des Links und Auslesen des Linktextes (1. Linktext, 2. IMG-Title, 3. IMG-Alt) (Erkennung noch fehlerhaft)

- optionaler automatischer Import von Yahoo Backlinks, Bing Backlinks, Alexa Backlinks, etc.

- Import von CSV-Dateien z.B. Google WMT-Backlinks, automatisch auch denkbar, erfordert aber den Login

- Anlegen von Sub-Accounts mit verschiedenen Rechten (Admin, Mitarbeiter und externe Linkaufbauer)

- einstellbare Tabelleninformationen (Spalten ausblenden/einblenden)

- Export aller Daten per CSV

- Export aller Daten per XML-Schnittstelle

- Berechnung von Arbeitsstunden und Stundenlohn (basierend auf den Zeiten wann ein Sub-Account Links hinzugefügt hat, wielange die Pausen dazwischen waren und welcher Preis pro Link angesetzt wird).

- zusätzliche Auswertung wie erfolgreich ein Sub-Account arbeitet (follow, Link nach x Tagen wieder weg, etc.)

- statistische (grafische) Auswertung von Domain-Pop & IP-Pop

- statistische Auswertung von Whois-Daten

- statistische (grafische) Langzeitauswertung für das eigene Projekt und die Backlink-Seiten (Pagerank, Alexa, etc.)

- Domain- & Wortfilter zur Erkennung von unterschiedlichen Diensten (AVZ, SB, etc.) auf Communitybasis (d.h. jeder Nutzer kann eigene Filter vorschlagen)

- statistische (grafische) Auswertung von Linkkategorien (AVZ, SB, etc.), auch Langzeitauswertung

- Aliasdomains (werden nur akzeptiert, wenn korrekte 301 Weiterleitung auf Hauptdomain steht)

- Auswertung von Mitstreiter-Projekten

- manueller Refresh einzelner Datensätze

- Änderung des automatischen Prüfungsintervals der linkgebenden Seite (ich denke mal 14 Tage reichen als Minimum und 90 Tage als Maximum)

- Hervorhebung von Backlinks, die nicht mehr verfügbar sind oder die noch keinen Link gesetzt haben (z.B. wenn ein Linkeinbau angekündigt wurde, kann dieser bereits dem System hinzugefügt werden)

- optionale Emailbenachrichtung über ungültige Links, einstellbar nach nofollow, nicht indexierbar, entfernt, etc.

- Cloakingprüfung (Ausgabe als Googlebot)

- Sortierung nach allen bekannten Daten (PR, Alexa, Datum der letzten Prüfung, nach Erstellungsdatum, usw.)

- Schnellsuche basierend auf AJAX (wie Google Suchhilfe, nur mit direkter Ausgabe in der Tabelle)

- Schnellcheck der eigenen Rankingdaten (PR, Alexa, etc.)

- einstellbar wie viel Einträge pro Tabellenseite ausgegeben werden sollen (20, 50, 100, 250, 500, unendlich?)

- Auswertung nach Keyword-Häufigkeit (Linktext) bezogen aufs ganze Projekt oder bestimmte/häufigste Deeplinks

- Auslesen von SERPs (erst in ferner Zukunft bzw. eher in einem eigenen Tool)

- vielleicht auch noch interessant: www.abakus-internet-marketing.de/foren/ ... tml#605934

- History zu allen ermittelten Rankings und Staten zu URL, Host und Domain (nach Kalenderwochen, Darstellung als Grafik). Damit das Ranking von Anfang bis zum aktuellen Zeitpunkt genau nachvollzogen werden kann.

- Gruppierung nach Linkpartner

- Gruppierung nach Whois-Inhaber

- Gruppierung nach Server-IP

- Gruppierung nach Registrar (IP-Range)

- Prüfung auf hidden, wenn der Link exakt so wie der umgebende Text aussieht

- Prüfung auf noarchive, da das ein Indiz sein kann, dass der Inhaber den Link vor Google selbst ausschließt

- Wenn noarchive nicht gesetzt ist den Google Cache der Seite regelmäßig auslesen und selber archivieren

- Themengebiet der Domain auslesen bei Adplanner und DMOZ

- DMOZ-Eintrag der Domain prüfen (fast vergessen

- Yahoo-Verzeichnis-Eintrag der Domain prüfen

- Statuscode der linkgebenden Seite beim Crawlen speichern und zusätzlich neben "Link gefunden" auch "Seite geladen" ausgeben

- Falls eine Seite nicht den Status 200 zurückliefert, wird der Link als nicht gefunden markiert und der Intervall auf 24 Std. reduziert (um einen temporärer Ausfall ausschließen zu können), nach 3 Fehlversuchen wird wieder der Standardintervall ausgelöst. Schlägt der Standardintervall noch 2 weitere Male fehl, so wird die linkgebende Seite nicht mehr weiter geprüft, außer man löst manuell ein "Refresh" aus. Dann beginnt der Kreislauf wieder von vorne

Im Vordergrund bei dem Tool soll in jedem Fall die schnelle Bearbeitung liegen. D.h. keine großartigen Formulare, sondern möglichst viel automatisch. Um eine Automatik zu realisieren, muss jeder erstmal seine Projekte hinzufügen. Für jedes Projekt kann man dann Backlinkdaten sammeln. Beim Hinzufügen neuer Links sucht das Script dann nach Übereinstimmungen zu den Projekten und gibt die entsprechenden Linkdaten (Deeplink & Text) aus. Mit einem Klick auf Notizen kann man sofort per AJAX weitere Informationen hinzufügen ohne die Tabelle neu laden zu müssen.

Ein weiteres wichtiges Feature wird die XS-Ajax-Technologie sein. Hierbei tragen alle Mitglieder mit ihrem Browser dazu bei, wenn Daten von den verschiedenen Schnittstellen ausgelesen werden. Auf die Art wird das System sehr schnell und lässt sich auch nicht aushebeln. D.h. sobald die Daten zu den eigenen Backlinks erfasst wurden, werden die Daten der restlichen Mitglieder erfasst. Sollte sich also jemand zwischenzeitlich nicht auf der Seite bewegen, kann es sein, dass seine Backlinkdaten trotzdem schon aktualisiert wurden.

Umso mehr mitmachen, umso größer wird das Netzwerk und um so schneller sind die Daten aktualisiert.

Hier ein Einblick in die aktuelle Baustelle:

Auch wenn die Liste schon recht lang geworden ist, würde ich mich freuen, wenn Ihr noch weitere Vorschläge einbringt oder einfach mal sagt, was ihr bei anderen Tools so vermisst bzw. nervig findet.

Gruß