Du befindest Dich im Archiv vom ABAKUS Online Marketing Forum. Hier kannst Du Dich für das Forum mit den aktuellen Beiträgen registrieren.

Google generiert selbstständig Zahlen beim Crawling

-

Popeye

- PostRank 5

- Beiträge: 331

- Registriert: 22.10.2003, 11:33

- Wohnort: Dortmund

Hallo,

beim durchsehen meiner Log-Dateien entdecke ich, das der Googlebot scheinbar Fantasie-Zahlen crawlt, die weder von extern noch intern verlinkt sind.

Es ist ein SMF-Forum und die Gestaltung der URLs ist folgendermassen:

www.url.de/beitrag,zahl1.zahl2.html

Hierbei dürften aufgrund der Verlinlung bei "zahl2" Werte wie 0, 15, 30 fortlaufend vergeben sein.

Plötzlich werden bei "zahl2" beliebige Werte generiert und dadurch massig DC produziert.

Hat jemand ähnliches schon mal beobachtet bzw. wie kann man da Abhilfe schaffen.

Grüße

beim durchsehen meiner Log-Dateien entdecke ich, das der Googlebot scheinbar Fantasie-Zahlen crawlt, die weder von extern noch intern verlinkt sind.

Es ist ein SMF-Forum und die Gestaltung der URLs ist folgendermassen:

www.url.de/beitrag,zahl1.zahl2.html

Hierbei dürften aufgrund der Verlinlung bei "zahl2" Werte wie 0, 15, 30 fortlaufend vergeben sein.

Plötzlich werden bei "zahl2" beliebige Werte generiert und dadurch massig DC produziert.

Hat jemand ähnliches schon mal beobachtet bzw. wie kann man da Abhilfe schaffen.

Grüße

-

Popeye

- PostRank 5

- Beiträge: 331

- Registriert: 22.10.2003, 11:33

- Wohnort: Dortmund

Na super...

Dann nimmt das mit dem DC wohl kein Ende...

Kann ich eigentlich dann nur per robots.txt durch Zahlen, die nicht vorkommen dürfen verbieten über

disallow /*1.html

disallow /*2.html

etc...

Obwohl das echte Idiotie ist...

Dann nimmt das mit dem DC wohl kein Ende...

Kann ich eigentlich dann nur per robots.txt durch Zahlen, die nicht vorkommen dürfen verbieten über

disallow /*1.html

disallow /*2.html

etc...

Obwohl das echte Idiotie ist...

-

Rem

- PostRank 10

- Beiträge: 3786

- Registriert: 08.12.2005, 18:45

Es geht bei ähnlichen Taktiken nicht um DC, sondern um die Vermeidung von DC. Bei mir sind einige URLs im Index, bei denen der Crawler unnötige Parameter rausgekürzt hat. Der umgekehrte Fall ist mir noch NIE unter die Augen gekommen.

Das was Du "duchmachst" ist aber eh die bereits erwähnte Kategorie: testen, ob die Seite einen 404 zurückgibt.

Daher zu "www.url.de/beitrag,zahl1.zahl2.html"

Wenn da wirklich ein Punkt ist, dann könnte AcceptPathInfo Off in der htaccess schon hilfreich sein und einen klaren 404 zurückgeben. Wobei ich hierzu nicht Fachmann bin...

https://httpsd.apache.org/docs/2.0/mod/core.html

Die Ausgabe eines 404 ist definitiv die beste Lösung, da es z.B. auch lustiges Verlinken verhindert

Das was Du "duchmachst" ist aber eh die bereits erwähnte Kategorie: testen, ob die Seite einen 404 zurückgibt.

Daher zu "www.url.de/beitrag,zahl1.zahl2.html"

Wenn da wirklich ein Punkt ist, dann könnte AcceptPathInfo Off in der htaccess schon hilfreich sein und einen klaren 404 zurückgeben. Wobei ich hierzu nicht Fachmann bin...

https://httpsd.apache.org/docs/2.0/mod/core.html

Die Ausgabe eines 404 ist definitiv die beste Lösung, da es z.B. auch lustiges Verlinken verhindert

-

depp ich

- PostRank 9

- Beiträge: 1508

- Registriert: 06.12.2004, 12:59

Ist doch kein Problem.

Der Crawler checkt, was kommt, wenn eigentlich NICHTS kommen dürfte. Etwa um die 404er Seite zu sehen.

All diese Seiten werden natürlich nicht gelistet - klar.

DC wäre es, wenn du die Seiten tatsächlich verlinkt hast, und selbst das ist aus meiner Sicht mittlerweile kein Problem.

Sowas hatte ich versehentlich 8 Monate lang (2 identische Seiten unter verschiedene URLs verlinkt) - ich hab nichts davon bemerkt, die 2. Seite wurde einfach nicht gelistet - was sie ja sonst auch nicht wäre.

Kein Ranking-verlust, kein Besuchereinbruch - nichts zu spüren.

Der Crawler checkt, was kommt, wenn eigentlich NICHTS kommen dürfte. Etwa um die 404er Seite zu sehen.

All diese Seiten werden natürlich nicht gelistet - klar.

DC wäre es, wenn du die Seiten tatsächlich verlinkt hast, und selbst das ist aus meiner Sicht mittlerweile kein Problem.

Sowas hatte ich versehentlich 8 Monate lang (2 identische Seiten unter verschiedene URLs verlinkt) - ich hab nichts davon bemerkt, die 2. Seite wurde einfach nicht gelistet - was sie ja sonst auch nicht wäre.

Kein Ranking-verlust, kein Besuchereinbruch - nichts zu spüren.

-

Rem

- PostRank 10

- Beiträge: 3786

- Registriert: 08.12.2005, 18:45

Ich bin trotzdem der Meinung, dass ein gezielter 404 am besten ist, weil gerade schlecht programmierte Bots einfach auch Probleme beim Traffik verursachen können...

Daneben: wenn solche Seiten effektiv ausgegeben werden, kann können sie auch verlinkt werden - je nachdem wie der Black Hat Kumpane gerade lustig ist.

z.B. https://www.deinedomain.xy/seite.htm.analdildo

Daneben: wenn solche Seiten effektiv ausgegeben werden, kann können sie auch verlinkt werden - je nachdem wie der Black Hat Kumpane gerade lustig ist.

z.B. https://www.deinedomain.xy/seite.htm.analdildo

-

Popeye

- PostRank 5

- Beiträge: 331

- Registriert: 22.10.2003, 11:33

- Wohnort: Dortmund

Das Problem ist, das kein 404er kommen kann...

Syntax für "zahl2" ist die Nummer der Mitteilung im Thread.

Meint:

zahl1,15.html beginnt mit der 16.Mitteilung.

Die Abfolge ist wie erwähnt vorgegeben - und auch so in der Übersicht der Beiträge verlinkt.

zahl1.16.html ruft also die gleiche "ähnliche" Seite auf.

Syntax für "zahl2" ist die Nummer der Mitteilung im Thread.

Meint:

zahl1,15.html beginnt mit der 16.Mitteilung.

Die Abfolge ist wie erwähnt vorgegeben - und auch so in der Übersicht der Beiträge verlinkt.

zahl1.16.html ruft also die gleiche "ähnliche" Seite auf.

-

nerd

- PostRank 10

- Beiträge: 4023

- Registriert: 15.02.2005, 04:02

du musst mit rel="canonical" im <head> angeben wo sich die original seite befindet:Popeye hat geschrieben: Hat jemand ähnliches schon mal beobachtet bzw. wie kann man da Abhilfe schaffen.

auf

https://www.example.com/product.php?ite ... ionid=5678

sollte also im head folgendes stehen:

<link rel="canonical" href="https://www.example.com/product.php?item=swedish-fish" />

-

luzie

- PostRank 10

- Beiträge: 4228

- Registriert: 12.07.2007, 13:43

- Wohnort: Hannover, Linden-Nord

Ja, tatsächlich ist das weniger ein Google-Problem, sondern ein Problem deines Systems (Site-Struktur). Nicht-existente Adressen müssten error-404-(not found) ausgeben ^^

Da das hier schwer zu machen ist, könnte man die zweite Zahl als Adressen-Parameter ausgeben:

----- ../beitrag,zahl1.html?zahl2=15

statt

----- ../beitrag,zahl1.zahl2.html

(wäre vermutlich als rewrite leicht zu machen)

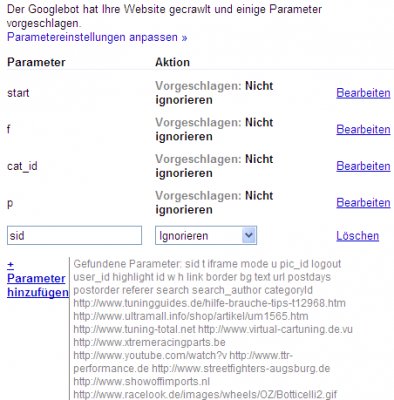

Den Parameter "zahl2" könnte man dann über die Parameterbehandlung in den Webmastertools vom Crawling ausschliessen.

Da das hier schwer zu machen ist, könnte man die zweite Zahl als Adressen-Parameter ausgeben:

----- ../beitrag,zahl1.html?zahl2=15

statt

----- ../beitrag,zahl1.zahl2.html

(wäre vermutlich als rewrite leicht zu machen)

Den Parameter "zahl2" könnte man dann über die Parameterbehandlung in den Webmastertools vom Crawling ausschliessen.

uzie - [url=httpss://plus.google.com/+HerbertSulzer/about]Google Official Bionic Top Contributor on Google Webmaster Central[/url]

uzie - [url=httpss://plus.google.com/+HerbertSulzer/about]Google Official Bionic Top Contributor on Google Webmaster Central[/url]-

Rem

- PostRank 10

- Beiträge: 3786

- Registriert: 08.12.2005, 18:45

Ja klar, da ist ein rewrite, das auf ein PHP verweist:

Könnte man den 404 nicht auch im Header durch das darunterliegende PHP-Skript erzeugen?

<?php

header("HTTP/1.0 404 Not Found");

?>

Sprich: im Skript müsste überprüft werden, ob eine "Sinnvolle Seite" aufgebaut werden kann und falls keine Daten vorhanden sind, wird einfach im Header ein 404 ausgegeben.

Das Problem ist dann zwar verschoben, aber wäre eventuell besser lösbar, als in der htaccess direkt...

Am besten wäre wohl, gleich am Anfang zu überprüfen, ob die Parameter innerhalb "festgelegter Grenzen" liegen und falls nicht, strikt ein 404 auszugeben.

Könnte man den 404 nicht auch im Header durch das darunterliegende PHP-Skript erzeugen?

<?php

header("HTTP/1.0 404 Not Found");

?>

Sprich: im Skript müsste überprüft werden, ob eine "Sinnvolle Seite" aufgebaut werden kann und falls keine Daten vorhanden sind, wird einfach im Header ein 404 ausgegeben.

Das Problem ist dann zwar verschoben, aber wäre eventuell besser lösbar, als in der htaccess direkt...

Am besten wäre wohl, gleich am Anfang zu überprüfen, ob die Parameter innerhalb "festgelegter Grenzen" liegen und falls nicht, strikt ein 404 auszugeben.

-

mgutt

- PostRank 10

- Beiträge: 3206

- Registriert: 08.03.2005, 13:13

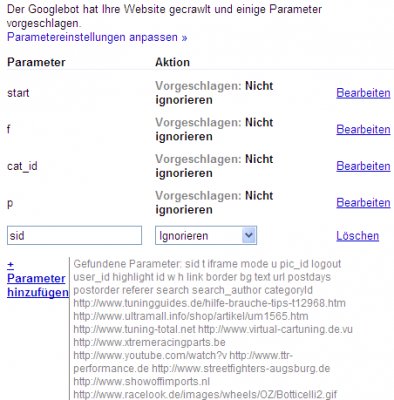

Das Ergebnís dieser Ermittlung siehst Du in den Webmastertools:

Zu hohe Startparameter leite ich per 301 auf die erste Seite weiter. 404 wollte ich nicht machen, da die eigentliche Unique-ID ja auf den passenden Inhalt verweist. Warum also den Besucher auf eine Fehlerseite lenken, wenn er doch eigentlich auf den richtigen Inhalt getroffen ist.

In Foren kommt es manchmal vor, dass nicht mehr existente Themenunterseiten verlinkt sind, weil ein Mod einige Beiträge entfernt hat.

Zu hohe Startparameter leite ich per 301 auf die erste Seite weiter. 404 wollte ich nicht machen, da die eigentliche Unique-ID ja auf den passenden Inhalt verweist. Warum also den Besucher auf eine Fehlerseite lenken, wenn er doch eigentlich auf den richtigen Inhalt getroffen ist.

In Foren kommt es manchmal vor, dass nicht mehr existente Themenunterseiten verlinkt sind, weil ein Mod einige Beiträge entfernt hat.

Ich kaufe Dein Forum!

Kontaktdaten

Kontaktdaten

-

Rem

- PostRank 10

- Beiträge: 3786

- Registriert: 08.12.2005, 18:45

Ich gebe Dir recht @mgutt, wobei man durchaus, wenn diese Zahl-Parameter logisch aufgebaut sind, z.B. von "15" (nicht existent) auf "14" weiterleiten kann. Das wäre logisch.

Wenn hingegen "166" getestet wird, ist ein 404 zurückzugeben richtiger, als dann auch auf die "14" umzuleiten? Ich will einfach sagen, dass eine Logik "nur 301 zurückzugeben" nicht unbedingt sinnvoll ist, weil es den "Status-Code" 404 ad absurdum führt und ich stark vermute, dass der Sinn von "Tests" seiten von den Sumas ja auch ist, das generelle Verhalten einer Seite - eben in Bezug auf 404 und 301 zu prüfen.

Wobei, klar bei "15" auf "14" kommt die Usability zuerst.

P.S. einer meiner ersten Hoster hat vor Jahren bei den Kunden-Fehlerseiten einen 200er ausgegeben . Die meisten Zugriffe kamen dann von Slurp. Täglich 10k PI auf einer Seite mit lediglich 2k Besucherzugriffen. Sprich: es gibt gute, schlechte und richtig dämliche Lösungen.

. Die meisten Zugriffe kamen dann von Slurp. Täglich 10k PI auf einer Seite mit lediglich 2k Besucherzugriffen. Sprich: es gibt gute, schlechte und richtig dämliche Lösungen.

Wenn hingegen "166" getestet wird, ist ein 404 zurückzugeben richtiger, als dann auch auf die "14" umzuleiten? Ich will einfach sagen, dass eine Logik "nur 301 zurückzugeben" nicht unbedingt sinnvoll ist, weil es den "Status-Code" 404 ad absurdum führt und ich stark vermute, dass der Sinn von "Tests" seiten von den Sumas ja auch ist, das generelle Verhalten einer Seite - eben in Bezug auf 404 und 301 zu prüfen.

Wobei, klar bei "15" auf "14" kommt die Usability zuerst.

P.S. einer meiner ersten Hoster hat vor Jahren bei den Kunden-Fehlerseiten einen 200er ausgegeben

-

mgutt

- PostRank 10

- Beiträge: 3206

- Registriert: 08.03.2005, 13:13

Dazu verweise ich mal auf meine Signatur. In einem Topic ist die Topic-ID gegeben. Ist die falsch gibts ne Fehlermeldung. Aber der Startparameter ist ja nur "Beilage". Ist Google denn überhaupt so dumm und schaut nach unlogischen Werten?

Ich kaufe Dein Forum!

Kontaktdaten

Kontaktdaten

-

- Vergleichbare Themen

- Antworten

- Zugriffe

- Letzter Beitrag

-

-

Google Search Console / Crawling / Crawling-Fehler

von dark_rider » 02.09.2017, 08:29 » in Google Forum - 0 Antworten

- 883 Zugriffe

-

Letzter Beitrag von dark_rider

02.09.2017, 08:29

-

-

- 5 Antworten

- 1196 Zugriffe

-

Letzter Beitrag von Rem

01.02.2018, 17:24

-

-

Google und Apple sollen mehr Steuern in Europa zahlen

von RH666 » 17.03.2018, 08:35 » in Infos, News & SEO Gerüchte - 5 Antworten

- 1315 Zugriffe

-

Letzter Beitrag von mits

16.07.2018, 07:49

-

-

-

Selbstständig und Leistungen durch das Amt?

von pimpi » 17.10.2016, 14:48 » in Ich hab' da mal 'ne Frage - 10 Antworten

- 1348 Zugriffe

-

Letzter Beitrag von Bodo99

23.10.2016, 17:12

-

-

- 35 Antworten

- 4726 Zugriffe

-

Letzter Beitrag von Lollipop

02.09.2016, 21:04

-

-

Google-Webmaster-Tools meldet 4000(!!) Crawling-Fehler (503)

von GeneralError » 06.05.2016, 14:37 » in Ich hab' da mal 'ne Frage - 2 Antworten

- 1851 Zugriffe

-

Letzter Beitrag von GeneralError

09.05.2016, 07:20

-

-

- 5 Antworten

- 1166 Zugriffe

-

Letzter Beitrag von Nokes

13.05.2016, 09:53