Du befindest Dich im Archiv vom ABAKUS Online Marketing Forum. Hier kannst Du Dich für das Forum mit den aktuellen Beiträgen registrieren.

Beiträge / Kommentare pro Seite - Blog vs. Forum

-

mgutt

- PostRank 10

- Beiträge: 3206

- Registriert: 08.03.2005, 13:13

In einem Blog werden alle Kommentare, egal wie viele es sind, unter dem Artikel angezeigt.

In einem Forum hat man dagegen in der Regel 10 - 30 Beiträge pro Seite.

Daraus ergibt sich ein klassischer Nachteil für das Forum.

Alle Unterseiten haben den gleichen Titel und die Unterseiten fallen so in den DC Filter. Weiterhin müssen Frage und Antwort keineswegs auf der gleichen Seite stehen. Falls also jemand ein Thema weiterempfiehlt, verteilen sich die Backlinks auf die verschiedenen Seiten eines Themas.

Unter dem Strich rankt also die Seite, die die meisten Backlinks besitzt (jetzt mal grob gesagt) und nicht die, die relevantesten Informationen besitzt.

Weiterhin ist davon auszugehen, dass 10 Backlinks verteilt auf 10 Unterseiten schlechtere SERPs resultieren als 10 Backlinks auf die Hauptseite des Themas.

Fragen:

1.) Nun überlege ich, wie man dem ganzen Herr werden könnte. Sollte man statt 10 bis 30 gar 100 oder unendlich viele Beiträge pro Seite ausgeben (ist das bei einem Blog eigentlich so)?

2.) Sollte man den Zugriff auf die Unterseiten verwehren und evtl. Backlinks auf die Hauptseite weiterleiten?

3.) Sollte man die Titel der jeweiligen Seiten optimieren (1. Satz aus dem 1. Beitrag, Seitenzahl, Keywordausgabe nach Dichte, Keywords aus Ref-Auswertung, usw.)?

4.) Sollte man sich AJAX zu nutze machen und mit Sprungmarken neue Inhalte nachladen, so dass der Besucher nur noch die Hauptseite mit Anker verlinkt und im Hintergrund der Suchmaschine alle Beiträge in einem Hidden Layer ausgeworfen werden (das wäre nicht verboten, da der Besucher weiterhin die Inhalte aufrufen kann)? Nachteil an der Variante wäre aber die schlagartige Reduktion von Seitenimpressionen, was sich vielleicht (es gibt keine Belege dafür) direkt auf das Ranking auswirken könnte. Je nach Größe der Seite, kann sich sowas auch negativ in der Presse auswirken, wie der letzte Bericht zwischen WKW und StudiVZ belegt.

In einem Forum hat man dagegen in der Regel 10 - 30 Beiträge pro Seite.

Daraus ergibt sich ein klassischer Nachteil für das Forum.

Alle Unterseiten haben den gleichen Titel und die Unterseiten fallen so in den DC Filter. Weiterhin müssen Frage und Antwort keineswegs auf der gleichen Seite stehen. Falls also jemand ein Thema weiterempfiehlt, verteilen sich die Backlinks auf die verschiedenen Seiten eines Themas.

Unter dem Strich rankt also die Seite, die die meisten Backlinks besitzt (jetzt mal grob gesagt) und nicht die, die relevantesten Informationen besitzt.

Weiterhin ist davon auszugehen, dass 10 Backlinks verteilt auf 10 Unterseiten schlechtere SERPs resultieren als 10 Backlinks auf die Hauptseite des Themas.

Fragen:

1.) Nun überlege ich, wie man dem ganzen Herr werden könnte. Sollte man statt 10 bis 30 gar 100 oder unendlich viele Beiträge pro Seite ausgeben (ist das bei einem Blog eigentlich so)?

2.) Sollte man den Zugriff auf die Unterseiten verwehren und evtl. Backlinks auf die Hauptseite weiterleiten?

3.) Sollte man die Titel der jeweiligen Seiten optimieren (1. Satz aus dem 1. Beitrag, Seitenzahl, Keywordausgabe nach Dichte, Keywords aus Ref-Auswertung, usw.)?

4.) Sollte man sich AJAX zu nutze machen und mit Sprungmarken neue Inhalte nachladen, so dass der Besucher nur noch die Hauptseite mit Anker verlinkt und im Hintergrund der Suchmaschine alle Beiträge in einem Hidden Layer ausgeworfen werden (das wäre nicht verboten, da der Besucher weiterhin die Inhalte aufrufen kann)? Nachteil an der Variante wäre aber die schlagartige Reduktion von Seitenimpressionen, was sich vielleicht (es gibt keine Belege dafür) direkt auf das Ranking auswirken könnte. Je nach Größe der Seite, kann sich sowas auch negativ in der Presse auswirken, wie der letzte Bericht zwischen WKW und StudiVZ belegt.

Ich kaufe Dein Forum!

Kontaktdaten

Kontaktdaten

Hochwertiger Linkaufbau bei ABAKUS:

Jetzt anfragen: 0511 / 300325-0

- Google-konformer Linkaufbau

- nachhaltiges Ranking

- Linkbuilding Angebote zu fairen Preisen

- internationale Backlinks

Jetzt anfragen: 0511 / 300325-0

-

chrizz

- PostRank 10

- Beiträge: 3044

- Registriert: 05.07.2006, 10:37

- Wohnort: Berlin

1) nein sollte man nicht, weil der gemeine Nutzer nicht ewig lang warten will, bis die Seite geladen ist. Bei Blogs kommt es drauf an. Wordpress hat eine Pagination-Funktion für Kommentare, von der aber im allgemeinen abgeraten wird.

2) also auch für User den Zugriff sperren? kontraproduktiv. Such mal einen Beitrag hier über die Abakus-Forensuche.

3) Hier wird nur das Thema in Title und Description angegeben. Den Rest (für die Snippets holt sich dann Google vermutlich meist selbst)

4) Wenn deine Seite als Kriterium irgendwo PIs nutzt, dann ist die Ajax Lösung sicherlich wenig hilfreich. Ansonsten versteh ich nicht, wie du das mit dem Ajax machen willst. Was ist so schlimm an mehreren Seiten pro Thema? Scheint doch hier wunderbar zu klappen...

Cheers

2) also auch für User den Zugriff sperren? kontraproduktiv. Such mal einen Beitrag hier über die Abakus-Forensuche.

3) Hier wird nur das Thema in Title und Description angegeben. Den Rest (für die Snippets holt sich dann Google vermutlich meist selbst)

4) Wenn deine Seite als Kriterium irgendwo PIs nutzt, dann ist die Ajax Lösung sicherlich wenig hilfreich. Ansonsten versteh ich nicht, wie du das mit dem Ajax machen willst. Was ist so schlimm an mehreren Seiten pro Thema? Scheint doch hier wunderbar zu klappen...

Cheers

-

mgutt

- PostRank 10

- Beiträge: 3206

- Registriert: 08.03.2005, 13:13

1.) Die Ladezeiten ändern sich kaum bei 100 Beiträgen pro Seite. Die leistet ja ein Blog genauso. Warum raten denn manche von der Pagination bei Wordpress ab? (vielleicht genau aus den Gründen, die ich zuvor nannte?)

2.) Ja für Gäste. Denke mir auch, dass das kritisch ist.

3.) Was hier gemacht wird sehe ich selbst. Mit Verlaub, Abakus ist keineswegs optimal. Ich habe mit modifizierten Titeln auf Themenunterseiten ganz neue Positionen erreicht. Dabei bin ich hingegangen und hab mir eine Keywordliste gebastelt und den Titel immer mit einem Keyword erweitert. Resultat: Die Haupt- oder Unterseite mit den meisten Zugriffen, rankt auch bei der Eingabe des eigentlichen Thementitels. Ich habe also mehr Besucher erreicht, verzerre aber dadurch das Hauptergebnis.

4.) Das mit AJAX/Javascript ist relativ easy. Im Grunde schmeißt man alle Beiträge so aus:

So schmeißt man die ersten 100-1.000 Beiträge aus (je nach Performance). Optisch gibt man dagegen ein Konstrukt aus Layern aus, dass sich per Klick auf eine Seitenzahl einen bestimmten Teilabschnitt des Hidden-Bereichs zieht. Jede Unterseite ist dann so verlinkt:

Seite 1: example.com/topic-titel

Seite 2: example.com/topic-titel#page2

Seite 3: example.com/topic-titel#page3

Bis hier hin braucht man nicht mal AJAX. Erst wenn das Thema recht groß ist, wird AJAX nötig, um weitere Beiträge nachladen zu können.

So landen dann im Index natürlich auch "nur" 100 bis 1.000 Beiträge, aber die Beständigkeit der Seite 1 URL ist gewahrt und zusätzlich entsteht ein besserer Keyword-Mix auf der Seite.

2.) Ja für Gäste. Denke mir auch, dass das kritisch ist.

3.) Was hier gemacht wird sehe ich selbst. Mit Verlaub, Abakus ist keineswegs optimal. Ich habe mit modifizierten Titeln auf Themenunterseiten ganz neue Positionen erreicht. Dabei bin ich hingegangen und hab mir eine Keywordliste gebastelt und den Titel immer mit einem Keyword erweitert. Resultat: Die Haupt- oder Unterseite mit den meisten Zugriffen, rankt auch bei der Eingabe des eigentlichen Thementitels. Ich habe also mehr Besucher erreicht, verzerre aber dadurch das Hauptergebnis.

4.) Das mit AJAX/Javascript ist relativ easy. Im Grunde schmeißt man alle Beiträge so aus:

Code: Alles auswählen

<div class="hidden">

<ul id="block1">

<li><span id="user1">Autorname1</span><br />

<span id="post1">Ich bin der 1. Beitrag</span></li>

<li id="block2">

<span id="user2">Autorname1</span><br />

<span id="post2">Ich bin der 2. Beitrag</span></li>

</ul>

</div>Seite 1: example.com/topic-titel

Seite 2: example.com/topic-titel#page2

Seite 3: example.com/topic-titel#page3

Bis hier hin braucht man nicht mal AJAX. Erst wenn das Thema recht groß ist, wird AJAX nötig, um weitere Beiträge nachladen zu können.

So landen dann im Index natürlich auch "nur" 100 bis 1.000 Beiträge, aber die Beständigkeit der Seite 1 URL ist gewahrt und zusätzlich entsteht ein besserer Keyword-Mix auf der Seite.

Das habe ich in meinem ersten Beitrag erklärt. 10 Backlinks auf die Themenhauptseite sind besser als 10 verteilt auf 10 Themenseiten. 10 schlecht rankende Themenunterseite bringen weniger als 1 gut rankender.Was ist so schlimm an mehreren Seiten pro Thema? Scheint doch hier wunderbar zu klappen...

Ich kaufe Dein Forum!

Kontaktdaten

Kontaktdaten

-

mgutt

- PostRank 10

- Beiträge: 3206

- Registriert: 08.03.2005, 13:13

Das wäre faktisch verboten, denn man darf nicht zwischen Bot und Gast bei der Ausgabe unterscheiden.Beloe007 hat geschrieben:du kannst per htaccess auch nur die Bots auf eine extra Ausgabe schicken, wo das Forum dann "flat" ist... Grafiken raus usw.. und du sparst noch traffic ^^

Du meinst eine Pagination hat Nachteile gegenüber dem einfachen Runterscrollen? Hab Deine Aussage jetzt nicht ganz verstandenAllerdings hat das auch Nachteile, die Besucher müssen dann immer erst den ganzen Thread durchackern bis sie auf der gewünschten Seite sind.

Ich kaufe Dein Forum!

Kontaktdaten

Kontaktdaten

-

Margin

- PostRank 10

- Beiträge: 4646

- Registriert: 09.09.2005, 08:25

Nö, User und Bot dürfen keine UNTERSCHIEDLICHEN Inhalte ausgeliefert werden.Das wäre faktisch verboten, denn man darf nicht zwischen Bot und Gast bei der Ausgabe unterscheiden.

In einem Forum können i. d. R. auch endlos viele Beiträge untereinander angezeigt werden, worauf ich jedoch aus Rücksicht auf den User grundsätzlich verzichte (ist einfach krank planlos durch "99" Postings zu scrollen).

Die Backlink-Problematik ist mir bis heute nie aufgefallen, da ich bislang eigentlich nur verlinkte Threads gefunden habe - verlinkte Einzelpostings auf der x-ten Unterseite sind eigentlich die absolute Ausnahme (bei mir).

DC entsteht auch nicht wirklich, da nicht davon auszugehen ist, dass auf Seite 2 - 8 die Postings die gleichen Inhalte haben, wie die auf Seite 1.

Für eine intensive User-Integration (und entsprechende Content-Generierung) ist ein Forum in jedem Fall die bessere Wahl - macht aber auch ein wenig mehr Arbeit.

-

mgutt

- PostRank 10

- Beiträge: 3206

- Registriert: 08.03.2005, 13:13

Google sagt:Margin hat geschrieben:Nö, User und Bot dürfen keine UNTERSCHIEDLICHEN Inhalte ausgeliefert werden.

Wenn man Grafiken ausblendet und damit auch die alt/title Attribute, verfälscht man nicht nur die Optik, sondern auch den Content.Erstellen Sie Seiten in erster Linie für Nutzer, nicht für Suchmaschinen. Versuchen Sie nicht, Ihre Nutzer zu täuschen. Stellen Sie zudem keinen Content für Suchmaschinen bereit, den Sie nicht für Ihre Besucher verwenden. Dies wird als "Cloaking" bezeichnet.

Bei der AJAX-Idee wäre alles wie gewohnt. Die Frage ist, warum können Blogger mit dem Scrollen leben und Forenuser nicht?In einem Forum können i. d. R. auch endlos viele Beiträge untereinander angezeigt werden, worauf ich jedoch aus Rücksicht auf den User grundsätzlich verzichte (ist einfach krank planlos durch "99" Postings zu scrollen).

Wundert mich auch nicht, da sich viele natürliche Empfehlungen in der Regel durch die SERPs selbst ergeben. Einer stellt eine Frage, ein anderer findet Deine Seite und damit die 1. Seite Deines Themas. Aber es gibt auch durchaus Backlinks mit Themenunterseiten. Und sofern Dein Forum nicht optimiert wurde, auch Direktlinks auf Beiträge.Die Backlink-Problematik ist mir bis heute nie aufgefallen, da ich bislang eigentlich nur verlinkte Threads gefunden habe - verlinkte Einzelpostings auf der x-ten Unterseite sind eigentlich die absolute Ausnahme (bei mir).

Das ist falsch, denn wenn es kein DC wäre, würden bei der Eingabe eines Thementitels alle Seiten ausgegeben und nicht einfach nur die Themenhauptseite. Es ist dabei unerheblich, ob sich der Thementitel im Text wiederholt. Natürlich ranken die Unterseiten auch, aber nur dann, wenn eine Suchphrase einen seltenen Inhalt findet und sofern es Mitstreiter in diesem Sektor gibt, ist die Klickrate logischerweise viel schlechter, weil unsere Titel sich nicht mit der Phrase decken.DC entsteht auch nicht wirklich, da nicht davon auszugehen ist, dass auf Seite 2 - 8 die Postings die gleichen Inhalte haben, wie die auf Seite 1.

Davon wollte ich auch nicht ab. Es geht mir nur um die Darstellungsweise. Im Urforum war ja jeder Beitrag sogar noch auf einer einzelnen Seite.Für eine intensive User-Integration (und entsprechende Content-Generierung) ist ein Forum in jedem Fall die bessere Wahl - macht aber auch ein wenig mehr Arbeit.

Ich kaufe Dein Forum!

Kontaktdaten

Kontaktdaten

-

mgutt

- PostRank 10

- Beiträge: 3206

- Registriert: 08.03.2005, 13:13

Wenn eine Druckansicht verfügbar ist, dann ist sie unter einer anderen URL aufrufbar. Das ist ein kleiner Unterschied. Inhalte für die Suchmaschine ausblenden ist genauso Cloaking, wie extra welche einzublenden, wenn auch der Verstoß bei letzterem schwerer liegt.Beloe007 hat geschrieben:Nenne es halt Druckansicht... wenn du dir unsicher bist.

D.h. Du meinst, dass ein Blog nur deswegen eine stupide Auflistung hat, weils eh kaum einen interessiert? Naja kommt auf den Blog anKommentare werden selten wirklich gelesen denke ich... bei einem Forum dagegen ist die Übersicht eine wichtige Eigenschaft.

Ich kaufe Dein Forum!

Kontaktdaten

Kontaktdaten

-

mgutt

- PostRank 10

- Beiträge: 3206

- Registriert: 08.03.2005, 13:13

Damit würde sich die URL-Struktur bei jedem Benutzer anders verhalten. Insofern würde man Backlinks provozieren, die andere gar nicht nutzen könnten. So wie früher bei Frameseiten, wo die URL auch nichts über die Seite ausgesagt hat. Das stiftet also eher Verwirrung in der Bedienung.Beloe007 hat geschrieben:Unter Content verstehe ich Inhalt = Der Text sollte derselbe sein, das Ganze drumherum ist da egal - meine Meinung.

Oder biete halt die Möglichkeit an ein Forum flach anzuzeigen, bei vielen kann man als Benutzer selbst einstellen wieviele Beiträge man auf einer Seite haben möchte...

Ne das lag eher daran, das es einfacher war einzelne Dateien zu generieren, als bestehende zu ändern. Gab ja noch kein PHP.Zu Zeiten als Traffic noch "teuer" war, wo die Foren herkommen, konnte es auch eine Kostenfrage gewesen sein mehrere Seiten anzubieten.

Ich glaube der Unterschied liegt einfach darin, dass ein Forum meist Regzwang hat und ein Blog Null Formatierungs- oder Zitatfunktionen besitzt. Eine durchlaufende Kommunikation ist da fast schon unmöglich. Aber ich habe auch schon in Blogs diskutiert, wo eine durchlaufende Kommunikation möglich war. Störend finde ich vor allen Dingen Trackbacks und der andere modische Kram, der zwischen den Kommentaren einen Bruch verursacht. Aber die Struktur eines Blogs wollte ich jetzt nicht thematisierenIch lese die Kommentare sehr sehr selten, schreibe in Blogs auch nie Kommentare(bzw. habe es noch nie gemacht) ^^ Wenn ich Infos aus den Kommentaren brauche nutze ich die Suchfunktion des Browsers, so das ich die ganzen "Toller Blog, gut geschrieben, ..." überspringen kann.

In einem Forum dagegen ist es meistens eine fortlaufende Diskussion, wo fast jeder Beitrag interessant sein kann. Und wenn mich ein Thema interessiert, ich bis Seite 10 gelesen habe... ein paar Tage später nochmal reinschaue das Thema auf 15 Seiten gewachsen ist, klicke ich auf Seite 11 und lese da weiter. Wenn es flach wäre müsste ich erst lange suchen bis ich die Stelle zum weiterlesen gefunden habe. Deshalb macht man auch Lesezeichen in ein Buch.

Btw. vielleicht lese ich aus dem Grund keine Blogkommentare, weil ich relativ einfach per Sofortsuche an die Stelle springen kann die ich brauche... bei einem Forum dagegen ist man gezwungen durchzublättern

Gehen wir doch mal zu der Javascript-Idee zurück. Diese würde ja die Bedürfnisse der üblichen Forenbedienung genügen und zusätzlich bessere Ergebnisse in den SERPs resultieren. Oder siehst Du das anders?

Ich stelle mir das so vor, dass das Forum ohne Javascript (Google) eine Seite mit 100 Beiträgen zeigt. Also auch eine Pagination mit jeweils 100 Beiträgen. Bei aktiviertem Javascript wird diese Auflistung dann in jeweils 10 Layer aufgeteilt und die Pagination entsprechend angepasst. Ein Klick auf Seite 11 lädt dann eine neue Seite mit wieder 100 Beiträgen die erneut mit Javascript in Layer aufgeteilt wird, usw. Damit würde die Seite komplett ohne AJAX auskommen. Klarer Nachteil wäre die Division aller Impressionen durch 10. D.h. für die Vermarktung evtl. ein Verlust und vielleicht auch fürs Ranking, aber das nur eine Theorie.

Ich könnte mir vorstellen, dass der Keywordmix auf einer Seite mit 100 Beiträgen besser ist und neben der einheitlichen Linkstruktur auch mehr Kombinationen ermöglicht. Weiterhin erhöht sie die möglichen Backlinks pro Seite.

Als Gegenargument kann hier denke ich nur zählen, dass Unterseiten mit optmierten Titeln besser ranken könnten.

Vielleicht mal ein Beispiel aus der Praxis:

Ich spiele schon länger mit den Titeln und bis vor kurzem hatte ich den folgenden Test laufen. Auf der Hauptseite ging der Titel so:

Auf der 1. Unterseite dagegen so:A3 gegen EJ9 - Forum: Civic 96-00 - Civic - Modelle

Wie man sieht habe ich einfach nur das Wort "Forum" gegen "Chat" getauscht. Ich selbst hatte herausgefunden, dass manche Leute ein Forum als Chat bezeichnen und daher dachte ich so mehr Zugriffe erreichen zu können.A3 gegen EJ9 - Chat: Civic 96-00 - Civic - Modelle

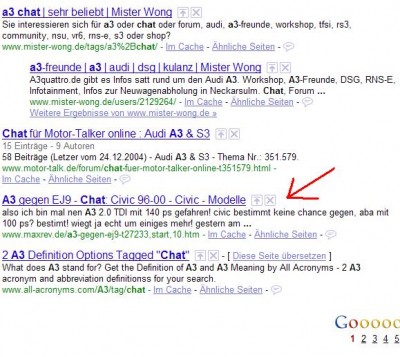

Was dann aber passiert ist, hat mich etwas stutzig gemacht. Laut WMT habe ich auf die Kombination "A3 Chat" ein paar Zugriffe erreicht. Dies geschah durch Pos 9 in den SERPs:

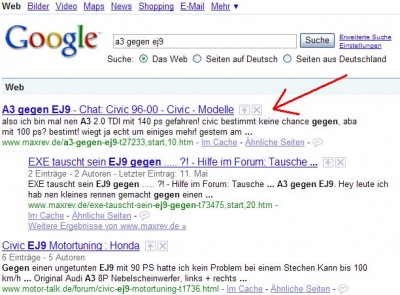

Gut dachte ich. Hat der "Trick" ja funktioniert und ich habe neue Türen geöffnet. Doch durch diese Zugriffe verlor die eigentliche Hauptseite des Themas ihren Wert für Google (DC-Filter). Bei der Suche nach dem eigentlichen Titel "A3 gegen EJ9" erscheint nun auch die Unterseite auf Platz 1:

Backlinks habe ich geprüft. Weder die Hauptseite noch die Unterseite hat welche. Intern sieht es anders aus. Da liegt die Hauptseite minimal vorne. Sie wird öfter verlinkt.

Aktuell teste ich übrigens auf der Unterseite:

Das ist der erste Satz aus dem ersten Beitrag. Ich wollte es erst andersherum machen, aber da spielen die User nicht mit.A3 gegen EJ9 - also ich bin mal nen A3 2.0...

Dieses Beispiel aus der Praxis belegt aber, dass bessere Unterseitentitel förderlich für neue Platzierungen sein können. Doch sobald der eigentliche Titel gesucht wird, verlieren alle Seiten, einschließlich der Hauptseite ihren Wert. Hier zählt nur die für Google relevanteste Seite und das ist nunmal die, die am meisten von den Besuchern angeklickt wurde.

Und das ist gleichzeitig das Gegenargument für 100 Beiträge (oder mehr) pro Seite. Zwar bringen 100 Beiträge mehr Keywords, doch gleichzeitig verhindert es das Spiel mit unterschiedlichen Titeln.

Was Abakus übrigens auf den Unterseiten einsetzt "Seite 2, 3, usw." bringt Null, sowas verschwindet einfach im DC Filter.

Ich kaufe Dein Forum!

Kontaktdaten

Kontaktdaten

-

mgutt

- PostRank 10

- Beiträge: 3206

- Registriert: 08.03.2005, 13:13

Nein die Relevanz ergibt sich durch die bisherigen Klicks auf diese Seite. Vermutlich hat die Seite 16 bei anderen Suchphrasen gute Klicks gesammelt, weshalb sie im direkten Relevanzvergleich zu Seite 13 als populärer eingestuft wurde.

Ich denke ich mache mal eine Statistik, in der ich sehen kann, wie oft die Antwortanzahl jeweils prozentual vertreten ist.

Was ich bei meinen Foren festgestellt habe ist, dass die Forenunterseiten bereits in der Sandbox gelandet sind bzw. deren URLs. Ich habe da zu spät über mehr Content (Textvorschau) und bessere Titel nachgedacht. Aber ich werde die URL-Struktur der Unterseiten denke ich eh noch mal ändern. Aktuell hänge ich ja ",start,10" an. Ich werde das noch kürzer gestalten.

Von der Angabe "Seite 2" hat kein Mensch was. Daher versuche ich mich mit dem 1. Satz des Beitrages dem Inhalt zu nähern. Aktuell überlege ich aber, ob es besser wäre, wenn man die Keywords mit der höchsten Dichte von dieser Seite extrahiert und in den Titel bringt. Wäre auch eine Möglichkeit. Auch das ist ein Mehrwert für den Nutzer.Aber wenn du dich bei der Content-Empfehlung dran hältst, die obige Regel ist in meinen Augen die wichtigste und die Benutzer kann man schlecht wiedergewinnen wenn sie mal merken das ein anderes Forum benutzerfreundlicher ist.

Ich denke ich mache mal eine Statistik, in der ich sehen kann, wie oft die Antwortanzahl jeweils prozentual vertreten ist.

Was ich bei meinen Foren festgestellt habe ist, dass die Forenunterseiten bereits in der Sandbox gelandet sind bzw. deren URLs. Ich habe da zu spät über mehr Content (Textvorschau) und bessere Titel nachgedacht. Aber ich werde die URL-Struktur der Unterseiten denke ich eh noch mal ändern. Aktuell hänge ich ja ",start,10" an. Ich werde das noch kürzer gestalten.

Ich kaufe Dein Forum!

Kontaktdaten

Kontaktdaten

-

bfs

- PostRank 2

- Beiträge: 44

- Registriert: 21.10.2008, 15:11

DC wird doch nicht nur am Seitentitel festgemacht, sondern an den Inhalten auf der Seite. Und die sollten sich ja schon unterscheiden, oder? Ausnahme hierbei wäre den ersten Beitrag eines Themas auf jeder Seite als erstes wieder anzuzeigen, dann wäre die DC Gefahr in der Tat hoch.mgutt hat geschrieben:Was Abakus übrigens auf den Unterseiten einsetzt "Seite 2, 3, usw." bringt Null, sowas verschwindet einfach im DC Filter.

Meines Erachtens ist "Seite n" anhängen garnicht so schlecht. Es verringert leicht die Keyword Density im Seitentitel und hilft Google so die paginierten Seiten von der Startseite des Themas abzugrenzen. Die "gepagten" Seiten ranken dann immernoch, wie du an deinem selbstgewählten Beispiel Abakus sehen kannst:

https://www.google.de/search?q=pr-sculpting+dickkopf

und sind also mitnichten in irgendwelchen DC Filtern verschwunden. Sie machen eben bloss den Hauptkeys der Startseite des Themas keine "Konkrrenz" mehr, und das ist eigentlich auch gut so, oder?

-

mgutt

- PostRank 10

- Beiträge: 3206

- Registriert: 08.03.2005, 13:13

Es bringt nichts die Seitenzahl auszugeben. Dein Beispiel funktioniert genauso gut, wenn die Zahl nicht da ist. Da 80-90% der Zugriffe über den Titel realisiert werden, greift hier sehr wohl ein DC-Filter. Aber nur eben dann, wenn nur die Keywords aus dem Titel gesucht werden, die auf allen Seiten verfügbar sind:

https://www.google.de/search?q=pr-sculpting+nofollow

Bei mir erscheint Abakus da erst auf Seite 2 und da dann komischerweise genau die Seite, die Du hervorgehoben hast (hat jemand auf das Ergebnis mit dem Dickkopf geklickt? ).

).

Und das ist meine Argumentation. Wäre es nicht besser, wenn mehr Beiträge auf der ersten Seite ständen, damit die Klicks, die durch "pr-sculpting dickkopf" generiert werden auch für die Hauptseite zählen?

Denk an mein Beispiel zuvor. Die Klicks auf ein Ergebnis zeigen Google wie wichtig ein Ergebnis gegenüber einem anderen ist. Stehen also auf der ersten Seite Ergebnisse, die selber keine Backlinks haben, zählt im Vergleich nur noch die Relevanz.

Also meine Argumente für mehr Beiträge pro Seite:

- 1.000 Klicks aus den SERPs auf die Hauptseite sind besser als 800 auf die Hauptseite und die restlichen 200 auf Unterseiten

- 10 Backlinks auf die Hauptseite sind besser als 8 auf die Hauptseite und 2 auf Unterseiten

Natürlich machen die Unterseiten wie gesagt nur 10-20% des Gesamttraffics aus, aber diese 10-20% können entscheidend dafür sein wie stark eine Seite rankt. Google unterscheidet ja nicht, ob es sich bei den URLs um das gleiche Thema handelt. Für Google sind es einfach nur unterschiedliche URLs mit Relevanz oder eben keiner.

Ich bin überzeugt, dass das der Grund ist, warum so viele Blog-Artikel vor Foren-Artikeln stehen. Hier ist die Breite der möglichen Kombinationen "Wort aus Titel + Wort aus einem Kommentar" enorm und erhöht jedes mal die Relevanz für "Wort aus Titel", so dass der Artikel auch bei den seitenspezifischen Kombinationen viel besser rankt.

https://www.google.de/search?q=pr-sculpting+nofollow

Bei mir erscheint Abakus da erst auf Seite 2 und da dann komischerweise genau die Seite, die Du hervorgehoben hast (hat jemand auf das Ergebnis mit dem Dickkopf geklickt?

Und das ist meine Argumentation. Wäre es nicht besser, wenn mehr Beiträge auf der ersten Seite ständen, damit die Klicks, die durch "pr-sculpting dickkopf" generiert werden auch für die Hauptseite zählen?

Denk an mein Beispiel zuvor. Die Klicks auf ein Ergebnis zeigen Google wie wichtig ein Ergebnis gegenüber einem anderen ist. Stehen also auf der ersten Seite Ergebnisse, die selber keine Backlinks haben, zählt im Vergleich nur noch die Relevanz.

Also meine Argumente für mehr Beiträge pro Seite:

- 1.000 Klicks aus den SERPs auf die Hauptseite sind besser als 800 auf die Hauptseite und die restlichen 200 auf Unterseiten

- 10 Backlinks auf die Hauptseite sind besser als 8 auf die Hauptseite und 2 auf Unterseiten

Natürlich machen die Unterseiten wie gesagt nur 10-20% des Gesamttraffics aus, aber diese 10-20% können entscheidend dafür sein wie stark eine Seite rankt. Google unterscheidet ja nicht, ob es sich bei den URLs um das gleiche Thema handelt. Für Google sind es einfach nur unterschiedliche URLs mit Relevanz oder eben keiner.

Ich bin überzeugt, dass das der Grund ist, warum so viele Blog-Artikel vor Foren-Artikeln stehen. Hier ist die Breite der möglichen Kombinationen "Wort aus Titel + Wort aus einem Kommentar" enorm und erhöht jedes mal die Relevanz für "Wort aus Titel", so dass der Artikel auch bei den seitenspezifischen Kombinationen viel besser rankt.

Ich kaufe Dein Forum!

Kontaktdaten

Kontaktdaten

-

- Vergleichbare Themen

- Antworten

- Zugriffe

- Letzter Beitrag

-

- 0 Antworten

- 285 Zugriffe

-

Letzter Beitrag von cosmico

28.02.2019, 16:15

-

-

Sin Webkataloge und Blog-Kommentare Spam?

von Debugger2 » 08.02.2016, 17:19 » in Domainpopularität / Link-Marketing, Backlinks aufbauen & Seeding - 6 Antworten

- 2161 Zugriffe

-

Letzter Beitrag von hanneswobus

11.02.2016, 10:32

-

-

-

(B) Kostenlose Kommentare auf meinem Blog

von superolli » 05.08.2018, 15:58 » in Marktplatz: Dienstleistungen - 0 Antworten

- 390 Zugriffe

-

Letzter Beitrag von superolli

05.08.2018, 15:58

-

-

-

Wordpress: Kommentare auf statischer Seite

von Enpi2000 » 15.06.2017, 20:38 » in Ich hab' da mal 'ne Frage - 2 Antworten

- 975 Zugriffe

-

Letzter Beitrag von Enpi2000

17.06.2017, 11:09

-

-

- 0 Antworten

- 815 Zugriffe

-

Letzter Beitrag von Herr.BB

29.11.2016, 11:36

-

-

Blog in bestehende Seite integrieren - Vorgehen so richtig?

von Ossings » 13.09.2016, 19:02 » in Ich hab' da mal 'ne Frage - 5 Antworten

- 1519 Zugriffe

-

Letzter Beitrag von mwitte

14.09.2016, 19:20

-

-

- 0 Antworten

- 312 Zugriffe

-

Letzter Beitrag von superolli

11.06.2018, 08:40